Несмотря на бешеный успех ChatGPT и других крупных языковых моделей, искусственные нейронные сети (ИНС), лежащие в основе этих систем, могут идти неверным путем.

Во-первых, ИНС «сверхмощны, – сказала Корнелия Фермюллер, специалист по информатике из Мэрилендского университета. – И иная проблема заключается в отсутствии прозрачности». Такие системы настолько сложны, что никто по-настоящему не понимает, что они делают и почему они работают так хорошо. Из-за этого, в свою очередь, почти невозможно заставить их рассуждать по аналогии, что и делают люди – используя символы для обозначения объектов, идей и отношений между ними.

Такие недостатки, вероятно, связаны с текущей структурой ИНС и их строительных блоков: отдельных искусственных нейронов. Каждый нейрон получает входные данные, выполняет вычисления и производит выходные данные. Современные ИНС представляют собой сложные сети этих вычислительных блоков, обученных выполнять определенные задачи.

Тем не менее ограничения ИНС уже давно очевидны. Рассмотрим, например, ИНС, которая различает круги и квадраты. Один из способов сделать это – иметь в выходном слое два нейрона, один из которых указывает на круг, а другой – на квадрат. Если вы хотите, чтобы ваша ИНС также различала цвет фигуры – синий или красный – вам понадобятся четыре выходных нейрона: по одному для синего круга, синего квадрата, красного круга и красного квадрата. Больше функций означает еще больше нейронов.

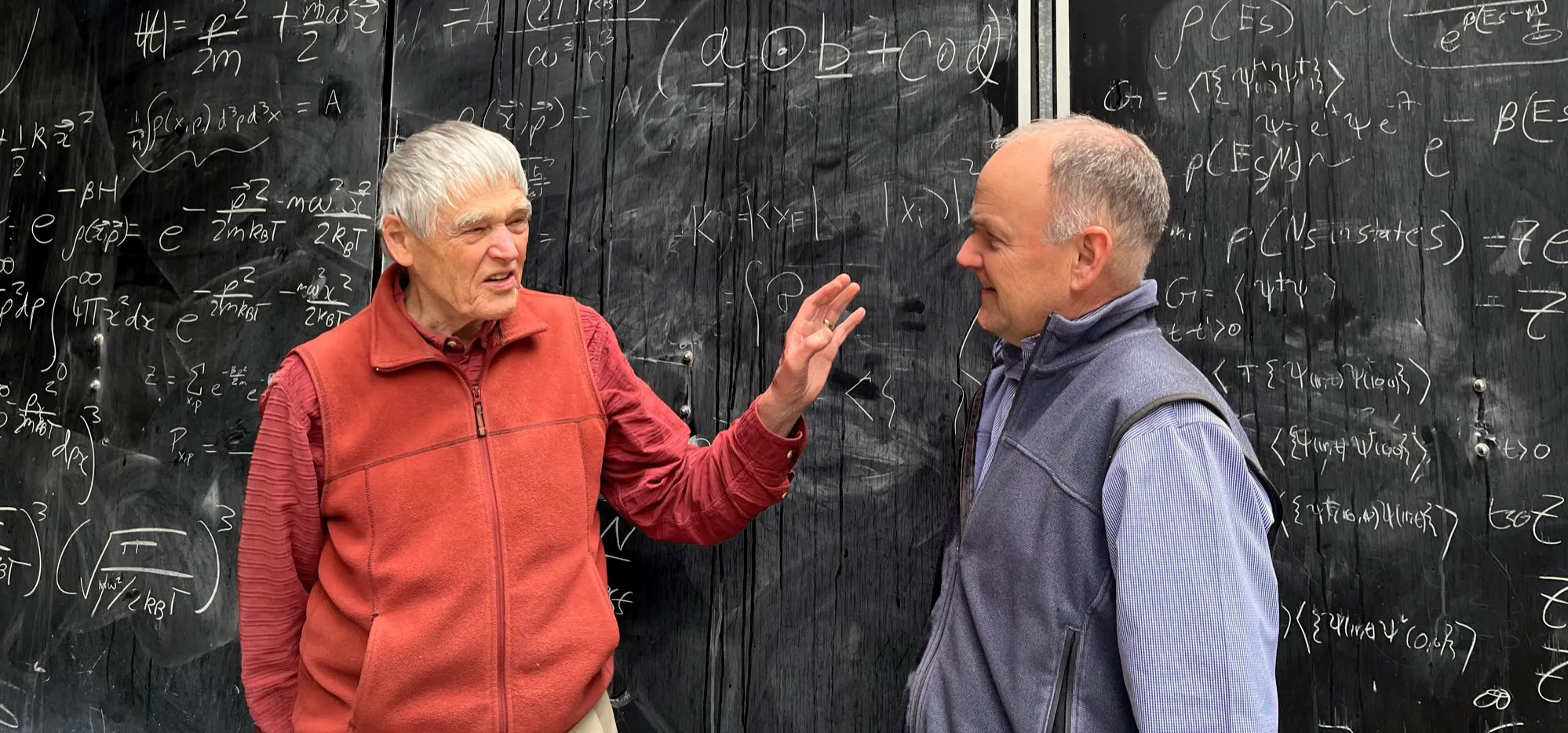

Наш мозг не может так воспринимать мир природы со всеми его вариациями. «Вы должны предположить, что у вас есть нейрон для всех комбинаций, – сказал Бруно Ольсхаузен, нейробиолог из Калифорнийского университета в Беркли. – Итак, у вас в голове будет, скажем, детектор фиолетового Volkswagen».

Вместо этого Ольсхаузен и другие утверждают, что информация в мозгу представлена активностью многочисленных нейронов. Таким образом, восприятие фиолетового «Фольксвагена» кодируется не как действие отдельного нейрона, а как действие тысяч нейронов. Один и тот же набор нейронов, возбуждающийся по-разному, может представлять совершенно другую концепцию (например, розовый Cadillac).

Это отправная точка для радикально иного подхода к вычислениям, известного как гиперпространственные вычисления. Суть в том, что каждая часть информации, такая как понятие автомобиля, его марка, модель или цвет, или все вместе, представлена как единое целое: гиперпространственный вектор.

Вектор – это просто упорядоченный массив чисел. Трехмерный вектор, например, состоит из трех чисел: координат x, y и z точки в трехмерном пространстве. Гиперпространственный вектор или гипервектор может быть массивом из 10 000 чисел, скажем, представляющим точку в 10 000-мерном пространстве. Эти математические объекты и алгебра для управления ими достаточно гибки и мощны, чтобы вывести современные вычисления за пределы некоторых существующих ограничений и способствовать новому подходу к искусственному интеллекту.

«Это то, что меня больше всего взволновало за всю мою карьеру», – сказал Ольсхаузен. Для него и многих других гиперпространственные вычисления обещают новый мир, в котором вычисления эффективны и надежны, а принимаемые машинами решения полностью прозрачны.

Откройте многомерные пространства

Чтобы понять, как гипервекторы делают возможными вычисления, давайте вернемся к изображениям с красными кругами и синими квадратами. Сначала нам нужны векторы для представления переменных SHAPE и COLOR. Затем нам также нужны векторы для значений, которые можно присвоить переменным: CIRCLE, SQUARE, BLUE и RED.

Векторы должны быть различными. Эта различность может быть количественно определена свойством, называемым ортогональностью, что означает нахождение под прямым углом. В трехмерном пространстве есть три вектора, которые ортогональны друг другу: один по оси x, другой по оси y и третий по оси z. В 10 000-мерном пространстве имеется 10 000 таких взаимно ортогональных векторов.

Но если мы позволим векторам быть почти ортогональными, количество таких различных векторов в многомерном пространстве резко возрастет. В 10 000-мерном пространстве есть миллионы почти ортогональных векторов.

Теперь давайте создадим отдельные векторы для представления SHAPE, COLOR, CIRCLE, SQUARE, BLUE и RED. Поскольку существует так много возможных почти ортогональных векторов в многомерном пространстве, вы можете просто назначить шесть случайных векторов для представления шести элементов; они почти гарантированно почти ортогональны. «Простота создания почти ортогональных векторов – основная причина использования гиперпространственного представления», – написал Пентти Канерва, исследователь Центра теоретической неврологии Редвуда при Калифорнийском университете в Бёркли, во влиятельной статье 2009 года.

Документ основан на работе, проделанной в середине 1990-х годов Канервой и Тони Плейт, в то время докторантами Джеффа Хинтона в Университете Торонто. Эти двое независимо друг от друга разработали алгебру для управления гипервекторами и намекнули на ее полезность для многомерных вычислений.

Учитывая наши гипервекторы для форм и цветов, система, разработанная Канервой и Плате, показывает нам, как манипулировать ими с помощью определенных математических операций. Эти действия соответствуют способам символического манипулирования понятиями.

Первая операция – умножение. Это способ объединения идей. Например, умножение вектора SHAPE на вектор CIRCLE связывает их в представление идеи «SHAPE – это CIRCLE». Этот новый «связанный» вектор почти ортогонален как SHAPE, так и CIRCLE. И отдельные компоненты можно восстановить – важная функция, если вы хотите извлечь информацию из связанных векторов. Имея связанный вектор, который представляет ваш Volkswagen, вы можете отменить привязку и получить вектор для его цвета: PURPLE.

Вторая операция, сложение, создает новый вектор, представляющий то, что называется суперпозицией понятий. Например, вы можете взять два связанных вектора, «SHAPE – это CIRCLE» и «COLOR – это RED», и сложить их вместе, чтобы создать вектор, представляющий круглую фигуру красного цвета. Опять же, суперпозиционный вектор можно разложить на составляющие.

Третья операция – перестановка; он включает в себя перестановку отдельных элементов векторов. Например, если у вас есть трехмерный вектор со значениями, помеченными x, y и z, перестановка может переместить значение x в y, y в z и z в x. «Перестановка позволяет создавать структуру, – сказал Канерва. – Это позволяет вам иметь дело с последовательностями, событиями, которые происходят одно за другим». Рассмотрим два события, представленные гипервекторами A и B. Мы можем совместить их в один вектор, но это уничтожит информацию о порядке событий. Сочетание сложения с перестановкой сохраняет порядок; события можно получить по порядку, обратив операции.

Вместе этих трех операций оказалось достаточно, чтобы создать формальную алгебру гипервекторов, допускающую символические рассуждения. Но многие исследователи не спешили осознать потенциал гиперпространственных вычислений, включая Ольсхаузена. «Это просто не укладывалось в голове», – сказал он.

Используя возможности

В 2015 году ученик Ольсхаузена по имени Эрик Вайс продемонстрировал один из аспектов уникальных возможностей гиперпространственных вычислений. Вайс придумал, как представить сложное изображение в виде единого гиперпространственного вектора, содержащего информацию обо всех объектах изображения, включая их свойства, такие как цвета, положения и размеры.

«Я чуть не упал со стула, – сказал Ольсхаузен. – Внезапно загорелась лампочка».

Вскоре другие команды начали разрабатывать гиперпространственные алгоритмы для воспроизведения простых задач, которые глубокие нейронные сети начали решать около двух десятилетий назад, таких как классификация изображений.

Рассмотрим аннотированный набор данных, состоящий из изображений рукописных цифр. Алгоритм анализирует особенности каждого изображения по некоторой заданной схеме. Затем он создает гипервектор для каждого изображения. Затем алгоритм добавляет гипервекторы для всех изображений нуля, чтобы создать гипервектор для концепции нуля. Затем он делает то же самое для всех цифр, создавая 10 гипервекторов «класса», по одному для каждой цифры.

Теперь алгоритму дается неразмеченное изображение. Он создает гипервектор для этого нового изображения, затем сравнивает гипервектор с сохраненными гипервекторами класса. Это сравнение определяет цифру, на которую больше всего похоже новое изображение.

Но это только начало. Сильные стороны гиперпространственных вычислений заключаются в способности составлять и разлагать гипервекторы для рассуждений. Последняя демонстрация этого произошла в марте, когда Аббас Рахими и его коллеги из IBM Research в Цюрихе использовали гиперпространственные вычисления с нейронными сетями для решения классической проблемы абстрактного визуального мышления – серьезной проблемы для типичных ИНС и даже для некоторых людей. Эта задача, известная как прогрессивные матрицы Равена, представляет изображения геометрических объектов, скажем, в сетке 3 на 3. Одна позиция в сетке пуста. Испытуемый должен выбрать из набора изображений-кандидатов изображение, которое лучше всего соответствует пустой ячейке.

«Мы сказали: Это действительно… убийственный пример визуального абстрактного мышления, давайте займёмся этим», – сказал Рахими.

Чтобы решить проблему с помощью гиперпространственных вычислений, команда сначала создала словарь гипервекторов для представления объектов на каждом изображении; каждый гипервектор в словаре представляет объект и некоторую комбинацию его атрибутов. Затем команда обучила нейронную сеть исследовать изображение и генерировать биполярный гипервектор – элемент может быть +1 или –1 – максимально приближенный к некоторой суперпозиции гипервекторов в словаре. Таким образом, сгенерированный гипервектор содержит информацию обо всех объектах и их атрибутах на изображении. «Вы направляете нейронную сеть в осмысленное концептуальное пространство», — сказал Рахими.

После того, как сеть сгенерировала гипервекторы для каждого из контекстных изображений и для каждого кандидата на пустой слот, другой алгоритм анализирует гипервекторы для создания вероятностных распределений количества объектов в каждом изображении, их размера и других характеристик. Эти распределения вероятностей, которые говорят о вероятных характеристиках как контекста, так и изображений-кандидатов, могут быть преобразованы в гипервекторы, что позволяет использовать алгебру для прогнозирования наиболее вероятного изображения-кандидата для заполнения вакантной ячейки.

Их подход был точен почти на 88% в одном наборе задач, тогда как решения, основанные только на нейронных сетях, были точны менее, чем на 61%. Команда также показала, что для сеток 3 на 3 их система была почти в 250 раз быстрее, чем традиционный метод, использующий правила символической логики для рассуждений, поскольку этот метод должен искать в огромном своде правил, чтобы определить правильный следующий шаг.

Многообещающее начало

Мало того, что гиперпространственные вычисления дают нам возможность символически решать проблемы, они также решают некоторые мелкие проблемы традиционных вычислений. Производительность современных компьютеров быстро снижается, если ошибки, вызванные, скажем, случайным переворотом бита (0 становится 1 или наоборот), не могут быть исправлены встроенными механизмами исправления ошибок. Более того, эти механизмы исправления ошибок могут снижать производительность до 25%, говорит Сюнь Цзяо, специалист по информатике из Университета Вилланова.

Гиперпространственные вычисления лучше переносят ошибки, потому что даже если гипервектор подвергается значительному количеству случайных перестановок битов, он все равно близок к исходному вектору. Это означает, что любые рассуждения, использующие эти векторы, не оказывают существенного влияния на ошибки. Команда Цзяо показала, что эти системы как минимум в 10 раз более устойчивы к аппаратным сбоям, чем традиционные ИНС, которые сами по себе на несколько порядков более устойчивы, чем традиционные вычислительные архитектуры. «Мы можем использовать всю эту устойчивость для разработки эффективного оборудования», – сказал Цзяо.

Еще одним преимуществом гиперпространственных вычислений является прозрачность: алгебра ясно говорит вам, почему система выбрала тот ответ, который она сделала. Этого нельзя сказать о традиционных нейронных сетях. Ольсхаузен, Рахими и другие разрабатывают гибридные системы, в которых нейронные сети преобразуют объекты физического мира в гипервекторы, а затем в дело вступает гиперпространственная алгебра.

«Такие вещи, как рассуждения по аналогии, просто ложатся вам на колени», – сказал Ольсхаузен. – Это то, что мы должны ожидать от любой системы искусственного интеллекта. Мы должны понимать его так же, как мы понимаем самолет или телевизор».

Все эти преимущества, по сравнению с традиционными вычислениями, предполагают, что гиперпространственные вычисления хорошо подходят для нового поколения чрезвычайно надежного оборудования с низким энергопотреблением. Они также совместимы с «вычислительными системами в памяти», которые выполняют вычисления на том же оборудовании, на котором хранятся данные (в отличие от существующих компьютеров фон Неймана, которые неэффективно перемещают данные между памятью и центральным процессором). Некоторые из этих новых устройств могут быть аналоговыми и работать при очень низком напряжении, что делает их энергоэффективными, но также подверженными случайным шумам. Для вычислений фон Неймана эта случайность – «стена, за которую вы не можете выйти», – сказал Ольсхаузен. Но с гиперпространственными вычислениями «вы можете просто пройти через неё».

Несмотря на такие преимущества, гиперпространственные вычисления все ещё находятся в зачаточном состоянии. «Здесь есть реальный потенциал», – сказала Фермюллер. Но она отмечает, что его еще нужно протестировать на реальных проблемах и в более крупных масштабах, ближе к размеру современных нейронных сетей.

«Для масштабных задач требуется очень эффективное оборудование, – сказал Рахими. «Например, как эффективно искать более 1 миллиарда элементов?»

«Все это должно прийти со временем, – сказал Канерва. – Есть и иные секреты, которые хранят многомерные пространства. Я вижу в этом самое начало времени вычислений с векторами».